文章には、音がある。

読み手の中で鳴る、小さな音だ。

静かなエッセイのあとに、短い挨拶が置かれる。

「おはよう」とか、「いいですね」とか。

それ自体は悪くない。むしろ優しい。

けれど、挨拶のあとに続く言葉が、いつも同じ方向へ流れることがある。

本文の話題に触れているようで触れていない。

問いに答えているようで、問いを持ち去ってしまう。

そして、読んだ人の頭の中に、説明しづらい疲れだけが残る。

ここでは、コメント欄を荒らすための誰かを責めたいわけではない。

ただ、「議論にならない型」が何度も繰り返されると、文章の場は少しずつ痩せていく。

そのことを書いておきたい。

「結果が良ければそれでいい」

もちろん、それが真になる場面もある。

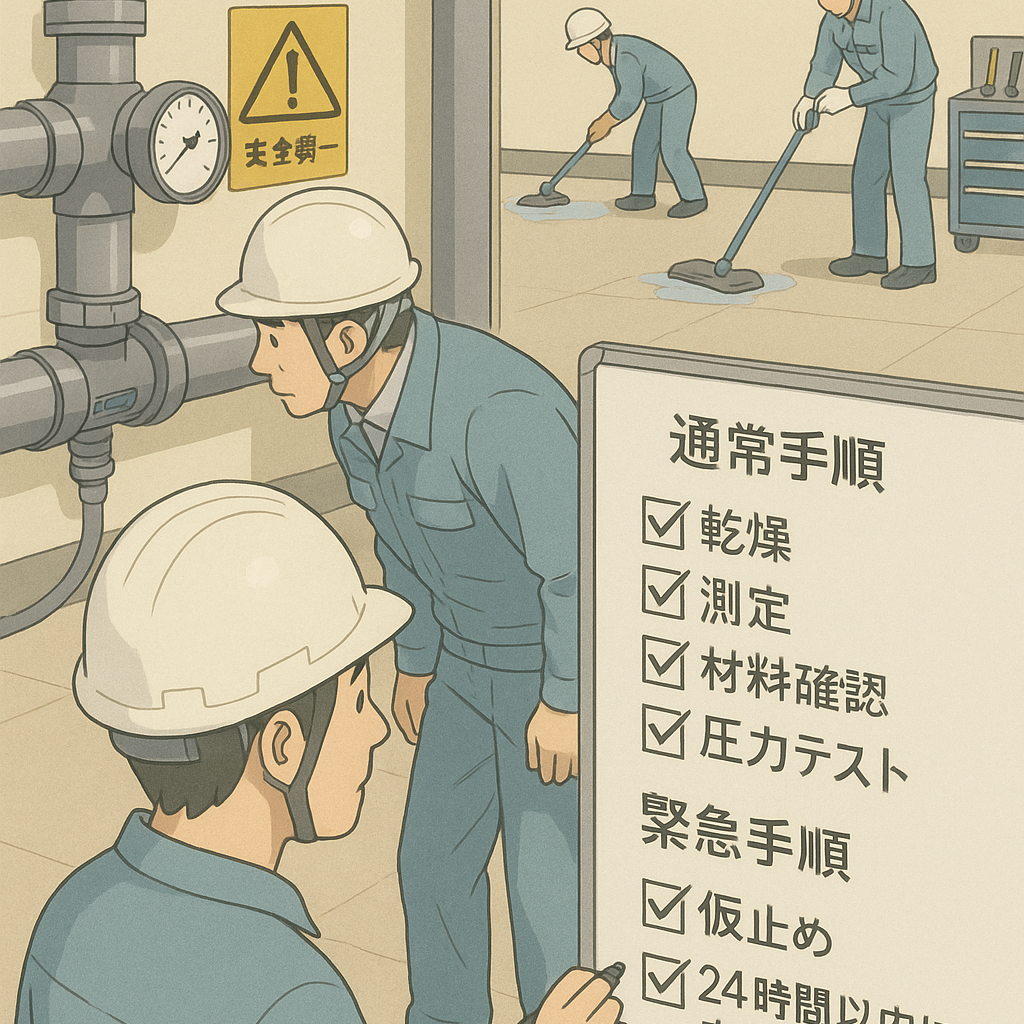

ただ、その一文が置かれた瞬間、本文が扱っていたもの――

プロセス、仕組み、検証、再発防止、契約、評価指標――

そういう“地味だけど大事なもの”が、ふっと消える。

結果論は、便利だ。

便利すぎて、たいていの問いを黙らせてしまう。

「権限がない人が言うべきではない」

これも、現場のリアルとして理解できる。

でも、その言葉が続くと、場はこうなる。

問いを立てる人が黙り、

数字を集める人が黙り、

改善案を置く人が黙り、

最後には、誰も書かなくなる。

権限は大事だ。

ただ、権限の話だけが前に出ると、思考は止まり、議論は終わる。

止まった議論は、また同じ問題を繰り返す。

「当事者は分かってるけどできないんだ」

これも真実であることが多い。

けれど、その真実は、使い方によっては霧になる。

霧は、傷を見えなくする。

見えない傷は、手当てが遅れる。

当事者のもどかしさを語るなら、

次の一歩も一緒に置いてほしい。

「だから、まずこれをやる」

「この条件なら、ここまでならできる」

霧の中に、道標を一本立てるように。

本や旅や流行や、昨日見たニュース。

話が広がるのは楽しい。

ただ、コメント欄は「舞台」になりやすい。

本文から少し逸れるだけなら問題はない。

でも、逸れ続けると、いつの間にか主役が入れ替わる。

文章の場は、書いた人のものでも、コメントした人のものでもない。

読んで持ち帰る人のものだ。

雑談が主題を覆うと、持ち帰るものが減っていく。

「頭が悪い」「笑いのツボ」

強い言葉は、短く刺さる。

刺さったあとに残るのは、思考ではなく、棘だ。

棘は、文章の場を「正しさの勝負」に変える。

勝負になると、長引く。

長引くと、読む人が減る。

減ったところに、強い言葉だけが残る。

だから私は、コメント欄を「勝負の場」にしたくない。

拍手も罵声も、どちらも音量が大きすぎる。文章の余韻を押しつぶしてしまう。

欲しいのは、もう少し小さな音だ。

本文のどこか一行に指を置いて、「私はこう読んだ」と言える音。

反対なら、反対の理由の隣に、せめて一つの代案を置く音。

その音は派手ではないけれど、読む人の中で長く残る。

短い挨拶は温かい。

けれど、挨拶だけで場は育たない。

結果論だけでは、検証が残らない。

権限論だけでは、工夫が生まれない。

当事者論だけでは、道が見えない。

雑談だけでは、主題が薄まる。

人格の棘だけでは、誰も持ち帰れない。

文章の場は、だれかを言い負かすためにあるのではなく、

読んだ人が明日を少しだけ良くするためにある。

だから私は、ここに残る言葉の形を整える。

必要なら、言葉の数を減らす。

反応が増える仕組みではなく、理解が深まる仕組みを選ぶ。

走る足音が消えたあとに、遅れて聞こえる声がある。

「助かった」という、小さな声だ。

私は、その声が聞こえる場所を、残しておきたい。